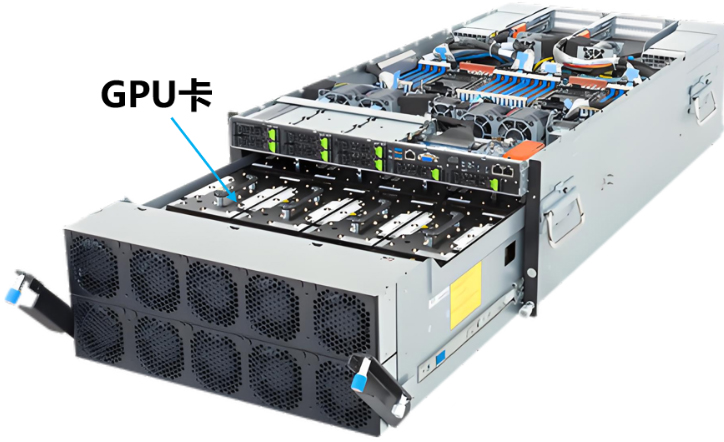

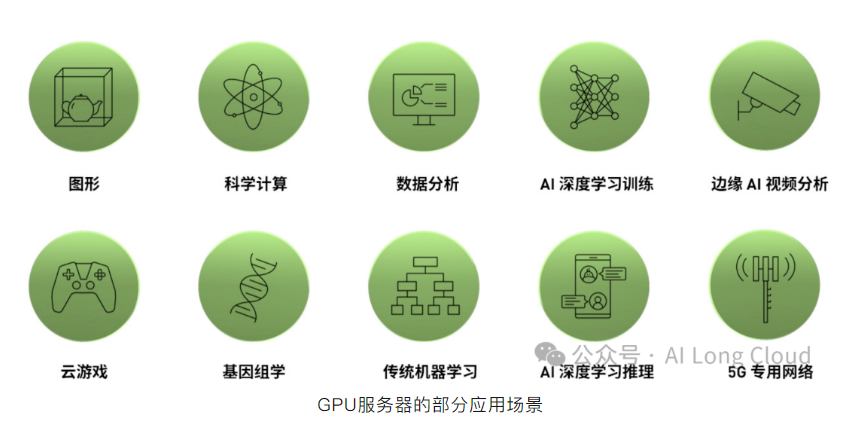

GPU服务器是一种配置了高性能图形处理器(GPU)的服务器,主要用于:提供高性能计算、深度学习、科学计算等多种场景的计算服务,用于处理大规模并行计算任务。说通俗一点就是装有GPU卡的服务器,不是那些有GPU显卡的个人电脑、或含有GPU芯片的手机这些。

与传统的通用中央处理器(CPU)服务器相比,GPU服务器在处理并行密集型计算任务时具有显著优势。GPU服务器通过将应用程序中计算密集的任务转移到GPU上,并释放出CPU的工作负荷,从而能够大幅提升应用程序的运行速度,以及数据处理效率。这对于需要处理大量数据的场景尤为重要,如视频编解码、深度学习、科学计算等。在这些场景中,GPU服务器能够提供比传统CPU服务器更高的计算性能和更低的能耗。

二、GPU服务器的分类

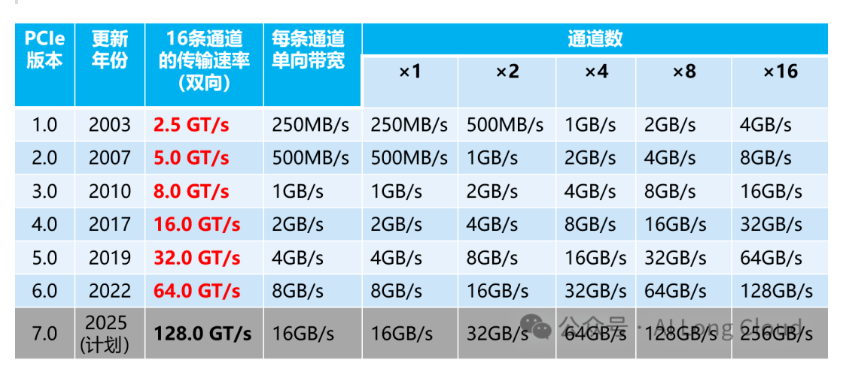

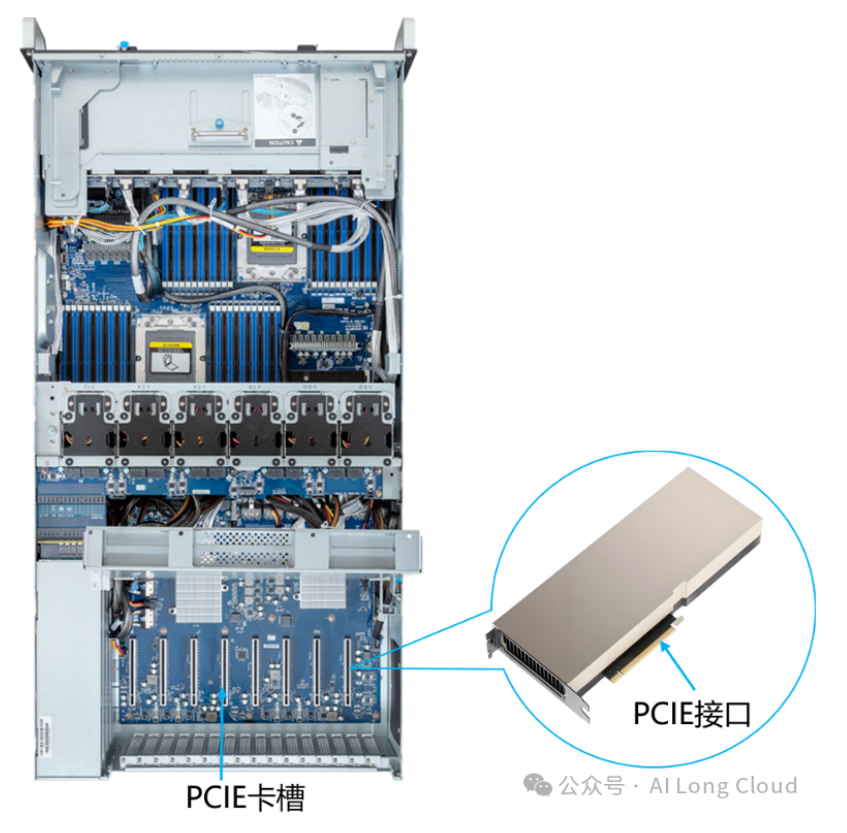

随着技术的不断的发展迭代,PCIe技术从原先的PCIe 1.0,逐渐发展到了PCIe 7.0。传输速率也从PCIe 1.0每秒 2.5Gbps,逐渐发展到PCIe 2.0每秒5Gbps,PCIe,3.0每秒8Gbps(因为编码的原因,所以2.0到3.0并不是数字看到的2倍关系),PCIe 4.0每秒16Gbps,PCIe 5.0每秒32Gbps,PCIe 6.0每秒64Gbps,PCIe 7.0每秒128Gbps。每一代 PCIe 的速度都是上代的2倍。

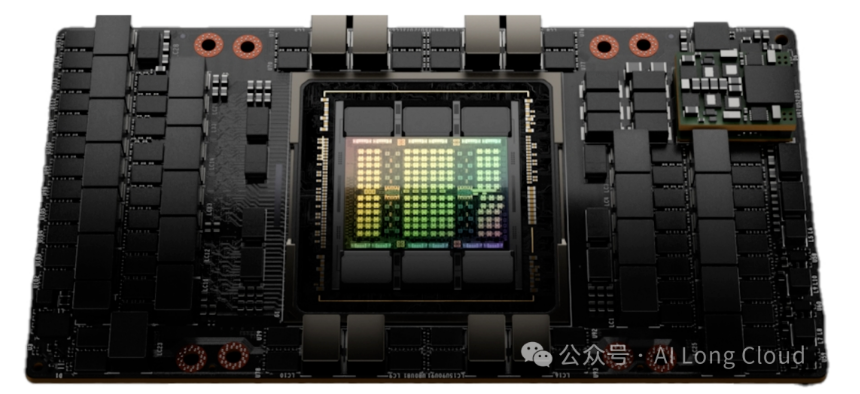

由于受限于PCIE的带宽上限,GPU卡与卡双向互联带宽比较低(目前最高的128GB/s),因此常见于早期的英伟达服务器(4090、L40、A100等),以及国产GPU服务器。

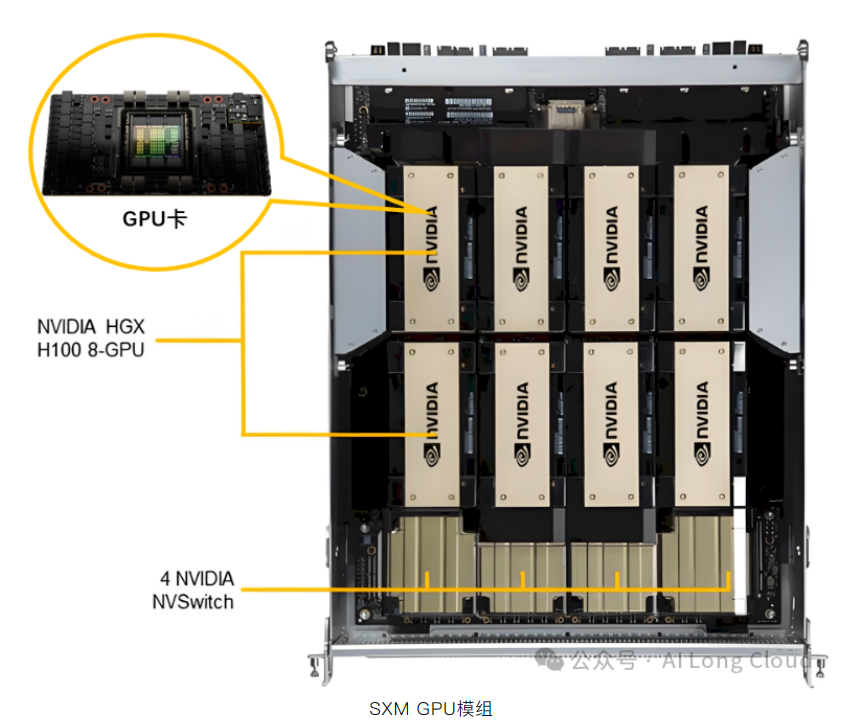

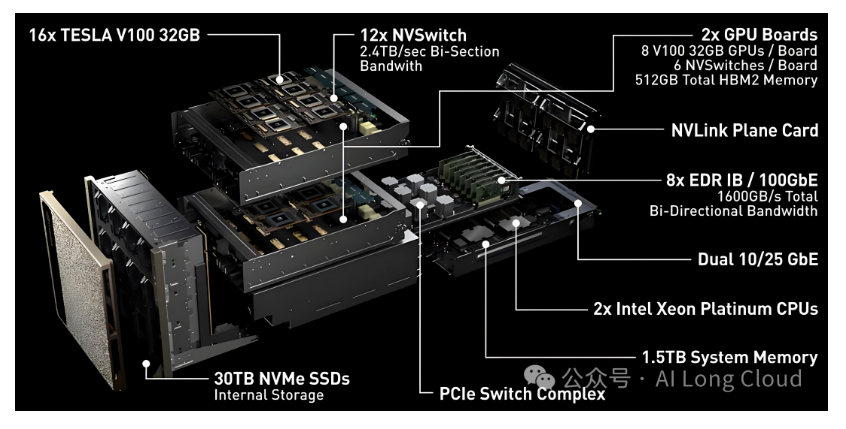

组装好了,有点像下面这个样子(以下是8张GPU卡的样子):

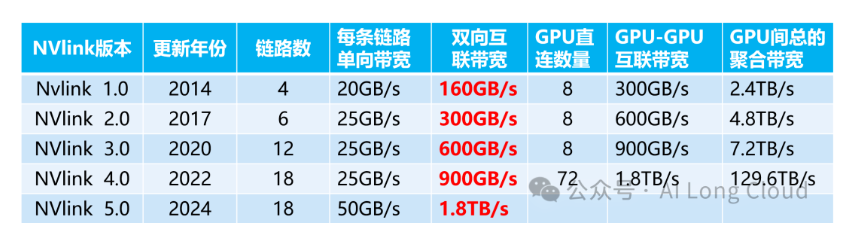

Nvlink技术随着GPU架构的演进不断发展,从P100的Nvlink1到H100的Nvlink4,再到GB200的Nvlink5。Nvlink 1.0、Nvlink 2.0、Nvlink 3.0、Nvlink 4.0和Nvlink5之间的关键区别在于连接的链路数量,包括GPU直连数量,最终表现出不同的带宽和性能。

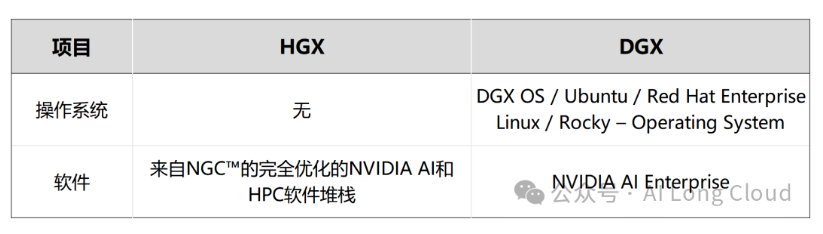

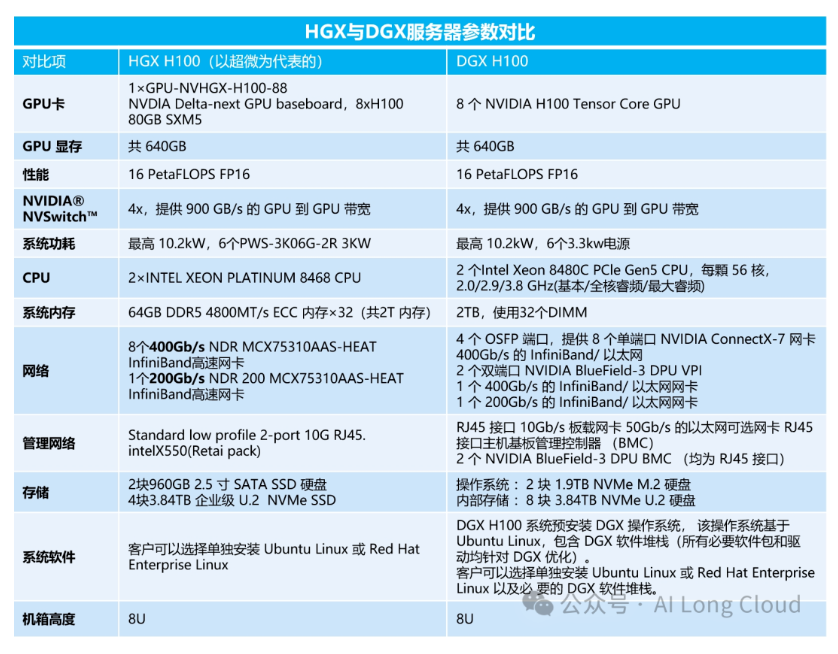

DGX作为一个完整的一体机,强调简易性和便捷性,可以快速部署和运行,适合需要即用型解决方案的大型企业。DGX通过如DGX SuperPOD这样的解决方案提供了很好的可扩展性,比如Nvidia最新发布的DGX GB200 SuperPod,由8个NVL72组成,共576个B200 GPU。

3)定制性

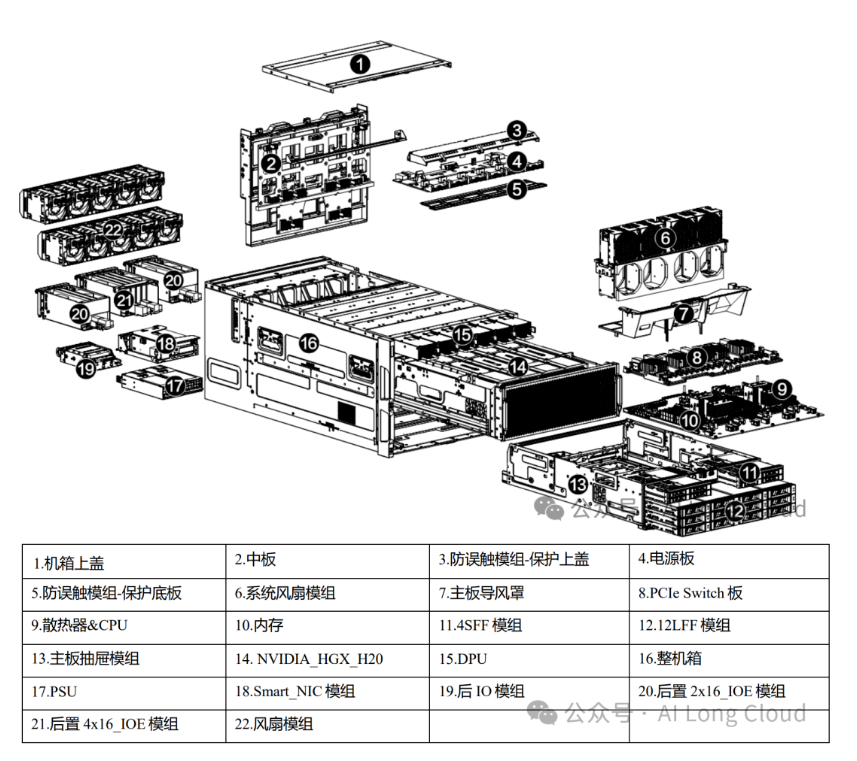

HGX只是英伟达提供的一个计算模组,用户根据计算需求添加或删除GPU数量,包括配置不同型号性能的CPU、硬盘、内存等;

DGX为一体机,不可随意定制,可定制性不如HGX,软硬件配置是固定的。

4)目标用户和应用场景

HGX主要面向需要灵活且可扩展的平台来满足高性能计算需求的研究人员和开发人员。适用于云数据中心、高性能计算、大规模人工智能研发、可定制基础设施等应用。

DGX专为需要强大、即用型AI解决方案的企业而设计。除HGX包含的目标外,还非常适合人工智能和深度学习开发、边缘计算、医疗保健和医学研究以及内容创建和媒体等应用。

5)运算性能

一种颠覆性的散热技术: 固态离子冷却技术

笔记本电脑通常依赖于小型风扇,利用风扇的空气流动将热量从散热部件带走。虽然这种风扇系统有效,但也有许多缺点,包括噪音、能效低以及尺寸的限制。为了解决这些问题,许多公司开始探索替代方案,例如使用固态散热技术。其中,Ventiva公司开发的离子空气冷却技术代表了一个重大突破。

液冷技术在新能源行业的应用场景

在当今全球能源结构加速转型的大背景下,新能源行业犹如一颗璀璨的新星,正以惊人的速度蓬勃发展。而液冷技术,作为一种卓越的高效热管理手段,在这一充满活力的领域中,展现出了无比独特且广阔的应用前景。本文将全面而详细地为您揭示液冷技术的原理、优缺点,以及其在新能源行业中的主要应用场景。

从设计到生产

灏域为您提供

全产业链解决方案

开始我们的合作

+86 18600523371