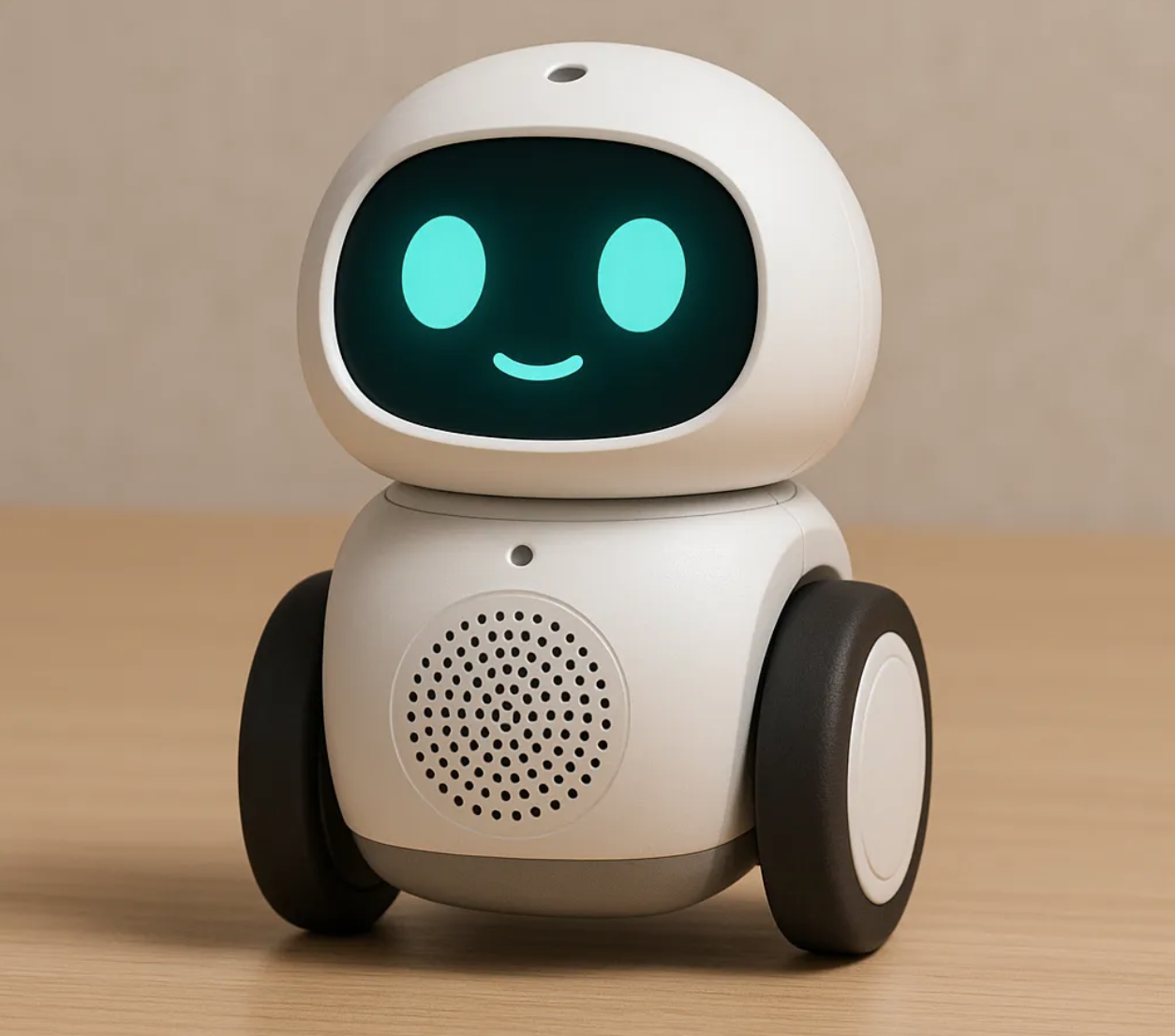

让网友通过编程制作一款桌宠机器人应该是个不错的方式,做成什么样子呢?现在有了GPT,来让万能的GPT帮着设计一个。先上它生成的效果图,是不是很Cute?

好,下面简单介绍一下我让GPT-5帮我设计的过程:

首先 - 提要求:

Q

我想设计一个桌宠机器人,能够在桌面上使用两轮自平衡走动,并能够通过语音控制,进行语音交互等功能。要求成本尽可能低,又有人工智能的功能,帮我设计一个方案。

GPT-5给出方案:

A

做一只“两轮自平衡 + 语音交互”的桌宠机器人,既要便宜又要有点儿 AI 灵魂。下面给你一套能落地、成本可控、后续可扩展的完整方案。

1. 系统目标与约束

桌面使用,安全、静音、占地小,运行时不冲撞。

两轮自平衡,支持原地转向、小幅位移,“点头/摇头”拟态表情。

语音交互:本地唤醒词 + 基础离线指令;联网时支持更丰富的云端对话/意图。

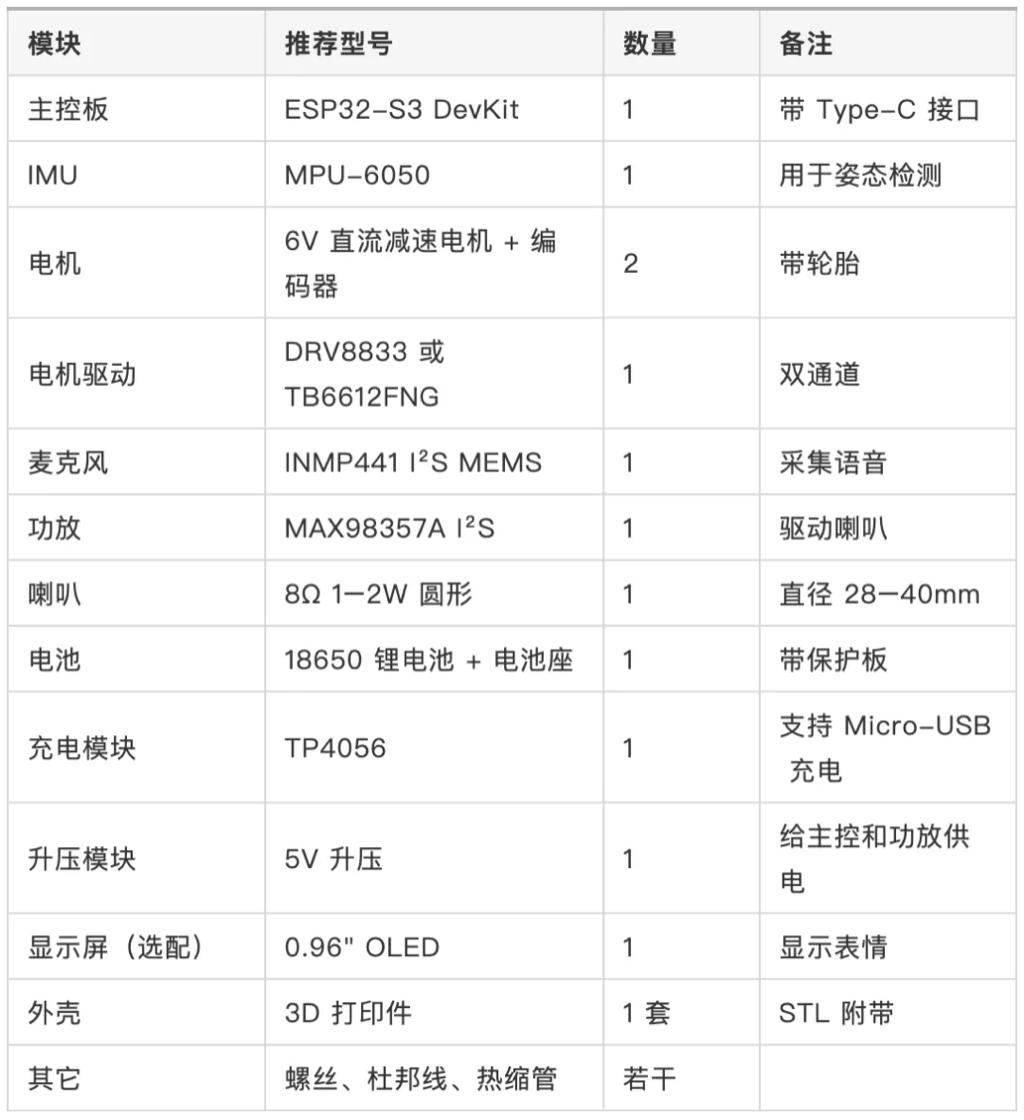

成本:基础版≈$25–$35(不含3D外壳);增强版(带屏和更好音频)≈$40–$55。

2. 硬件架构(推荐)

主控:ESP32‑S3(双核、AI指令、USB-OTG),自带Wi‑Fi/BT,跑实时控制+语音边缘模型绰绰有余。若更省钱:ESP32(WROOM)也可以,但USB与I2S资源紧张些。

IMU:MPU‑6050(超低价、社区成熟)或 ICM‑42688P(更稳)。I²C 接口。

电机:直流减速微型电机 6V 带编码器 ×2(编码器提升姿态/速度闭环质量;预算极紧可无编码器)。

电机驱动:DRV8833 或 TB6612FNG(PWM 驱动两路)。

语音输入:INMP441(I²S MEMS Mic) 或 SPH0645/ICS‑43434(同类)。I²S接入,抗噪好。

语音输出:MAX98357A I²S D类功放 + 8Ω 1–2W 小喇叭(音质>成本)。

显示(可选):0.96" I²C OLED 显示“眼睛/表情/电量/网络”,或超小TFT。

供电:18650 单节 + 保护板,TP4056 充电,升压到5V(音频/逻辑),电机可直接电池(3–4.2V)或另一路升压到6V(看电机额定)。再用 3.3V LDO 给IMU/主控。

其它:电源开关、碰撞/跌落保护(前置红外测距或微动开关,可后加)。

参考BOM(单价预估)

合计:基础(无屏/无编码器)≈$25–$35;完整(带屏/编码器/好音频)≈$40–$55。

3. 控制与算法

3.1 姿态估计

传感器:陀螺+加速度计(IMU)。

融合:互补滤波(Complementary Filter) 或 Madgwick。

互补滤波频段分工:角速度高频、加速计低频,采样≥500 Hz,滤波常数 α≈0.98 起步。

目标:获得精准的 倾角 θ 与 角速度 ω。

3.2 自平衡控制

内环:姿态角 PID(或 PD),外环:速度/位移环(用编码器或积分项约束漂移)。

控制频率:500–1000 Hz(IMU读取+控制计算);电机PWM更新≥20 kHz(安静)。

初始增益(经验起点,需现场整定):

角度环:Kp=18–28,Kd=0.5–1.2,Ki=0(先不启用)。

速度环(慢环,100 Hz):Kp=0.5–1.0,Ki=0.05–0.1。

安全:倾角超阈(如 >30°)立即切断PWM并落地保护。

3.3 运动与拟态

高层指令转化为目标速度/转向(v, ω),由外环限幅馈入内环。

拟态动作:短暂正反向俯仰实现“点头”;微幅左右轮速差实现“摇头”。

4. 语音与AI交互

4.1 本地(离线轻量)

唤醒词(例如:“小禾小禾”):使用 KWS(Keyword Spotting, TFLite Micro) 或第三方超轻唤醒库。

离线命令集(10–20条):如“跟我来”“停下”“点头”“转身”“唱歌”等。可用DS‑CNN/CRNN 语音指令识别小模型(8–20KB参数级别)。

本地TTS:空间紧张时可用预录音;或简易mbrola/ eSpeak移植(音色机械)。

4.2 联网(增强智能)

唤醒后,I²S 持续录音 → 音频片段经Wi‑Fi上传到云端 ASR/LLM → 返回自然语言回复 → TTS音频 下发播放。

策略:离线优先(指令级实时性),云端补充(闲聊/讲笑话/讲题/个性化)。

断网降级:仍可用本地命令与情绪表情。

5. 固件与任务划分(FreeRTOS)

Core0 / 高优先级:IMU采样+姿态融合(1kHz)、平衡控制(1kHz)、PWM输出。

Core1 / 中优先级:语音流采集(I²S DMA),唤醒词/KWS 推断(100–200ms窗口),本地命令识别。

网络/低优先级:Wi‑Fi连接、云端API、TTS缓存、UI与动画、日志。

安全卫士:跌落/碰撞/倾倒检测,中断式急停。

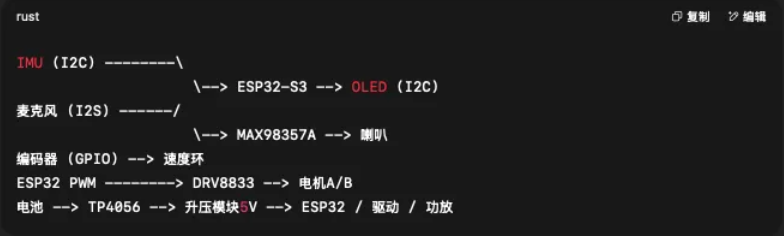

关键数据流

IMU→姿态融合→角度环PID→电机PWM

Mic(I²S)→KWS/命令识别→动作/对话→TTS(I²S)→功放

(可选)编码器→速度环→抗漂移/稳站

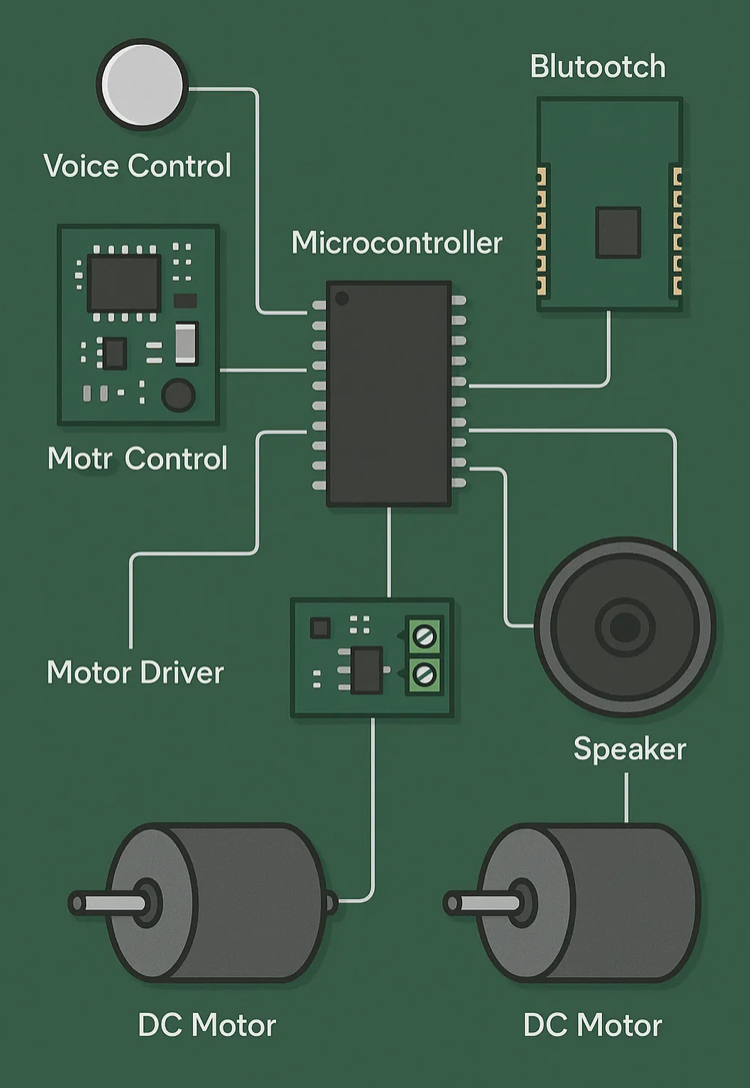

6. 参考原理连接(文字版)

ESP32‑S3:I²C0→MPU‑6050;I²S0‑RX→INMP441;I²S1‑TX→MAX98357A;PWM(LEDC)→DRV8833 AIN1/AIN2、BIN1/BIN2;GPIO→编码器A/B;I²C1→OLED。

电源:18650→保护板→5V升压→(MAX98357A、ESP32板);→3.3V LDO→IMU/OLED;电机侧可用电池直供或另升压至6V(视电机额定)。

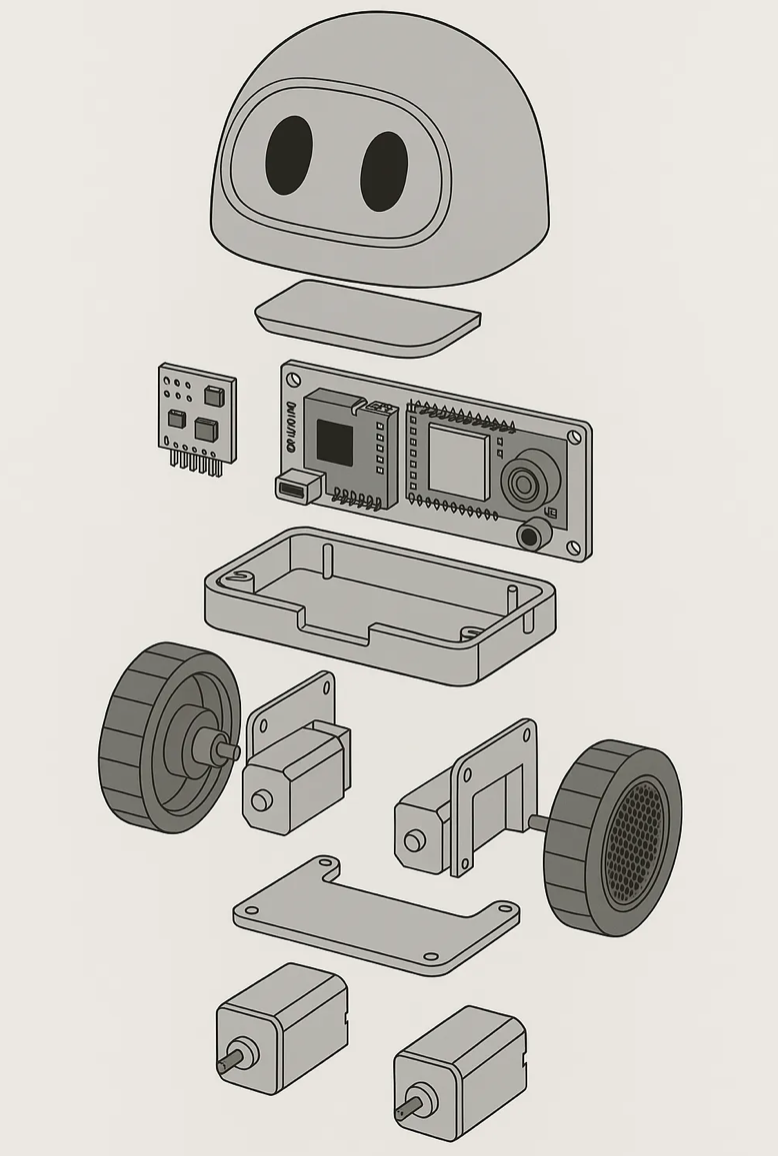

7. 机身与结构

差动两轮 + 顶部/前部配重靠近电机轴线,缩短质心到轮轴距离,降低控制难度。

3D打印外壳:底盘(电机、驱动、IMU、主控)、中层(电池、功放/喇叭箱体)、上盖(OLED“眼睛”、麦克风开孔)。

减震与噪声:电机与底盘间加TPU垫圈;轮胎用软胶圈,桌面更静音。

麦克风开孔前做声学管/防风棉,远离电机与气流。喇叭做小腔体提升音色。

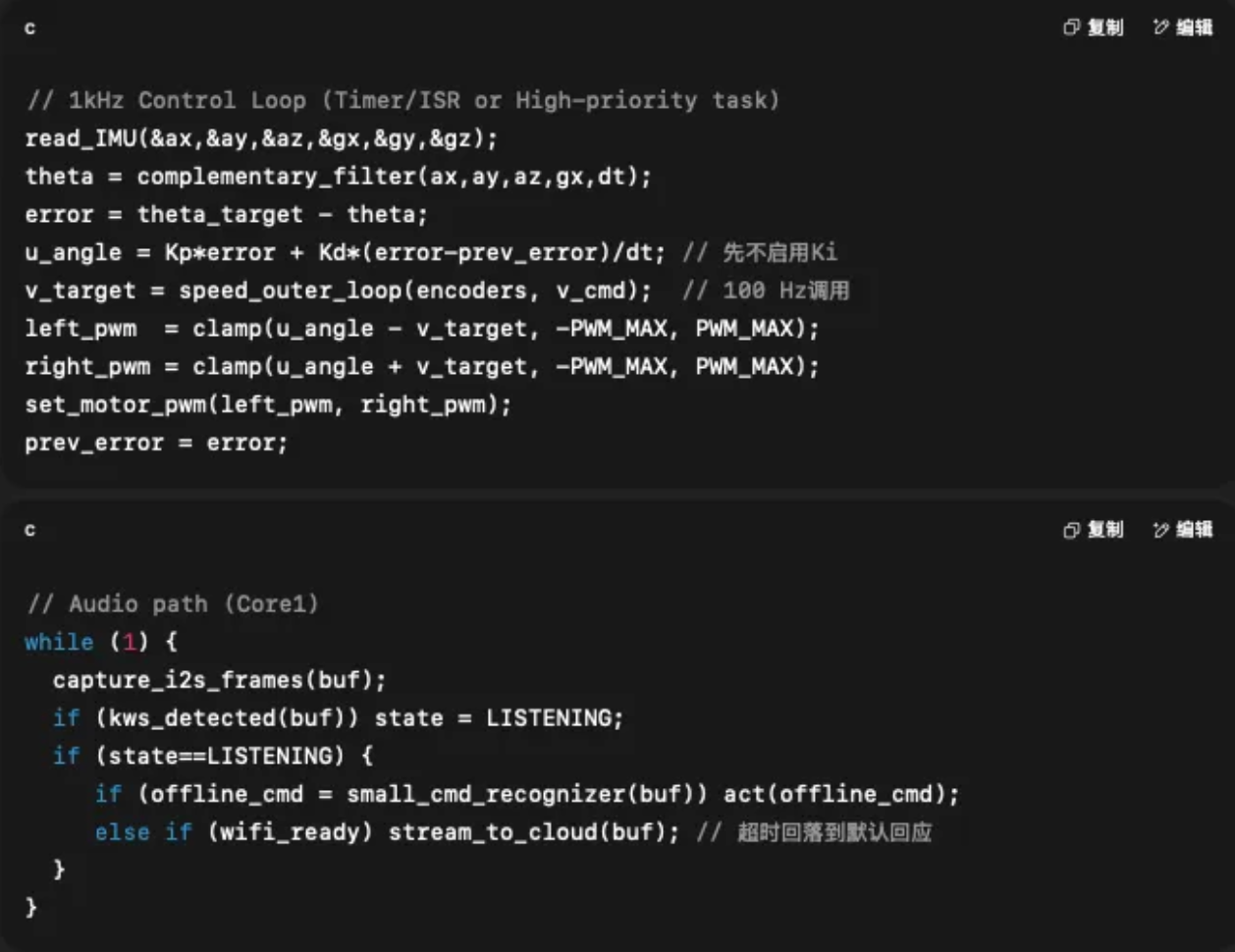

8. 软件要点与样例伪代码

9. 功耗与续航

空闲(待机听唤醒):70–120 mA(取决于Wi‑Fi与屏幕)。

自平衡+语音:250–500 mA 峰值可更高。

18650(2500 mAh)典型可玩 1–2.5 小时(取决于动作/音量/联网)。

10. 安全与测试

上机前:在支架上调参,限制PWM与倾角阈值;电池与线束固定牢靠。

桌面保护:边缘红外测距(前向或下视)或“桌边检测”微动开关,防跌落;速度限幅 < 0.3 m/s。

热管理:功放与电机附近留散热孔。

11. 开发里程碑(建议节奏)

Week 1:IMU读取与互补滤波 → 自平衡原型(无语音)跑通;基础PID整定与安全保护。

Week 2:加编码器外环、动作指令;接入KWS(离线10条命令);MAX98357A 播放提示音。

Week 3:云端ASR/LLM/TTS管线(可选);OLED表情与行为逻辑;3D外壳迭代;整机测试与调参。

12. 可选升级

小摄像头(ESP32‑S3‑Eye 或 OV2640 模组):做表情识别/跟随(成本上升)。

ToF/超声测距:避障更稳。

RGB LED/表情矩阵:情绪表现力更强。

无接触充电底座:更像“宠物”的栖息习惯。

我想看看它设计的这个小机器人什么样子,让它:

Q

帮我生成一下它的结构效果图

A

Q

帮我生成一个外包装盒的效果图

A

Q

画一下内部电路板的结构和连线关系

A

Q

帮我写一个使用手册,能够让大一的学生通过自己diy可以制作这么一个机器人

A

好的,我给你写一份适合大一学生的 DIY 桌宠机器人使用手册,内容会覆盖 材料准备、硬件组装、软件烧录与调试、使用与安全,并且尽量用浅显语言,让他们能一步步完成。

桌宠机器人 DIY 使用手册(适合大一电子信息类学生)

1. 项目简介

本机器人是一款 两轮自平衡 + 语音交互 的桌面宠物机器人。它能够在桌面上平稳行走,听懂一些简单的语音指令,还可以联网与人互动。通过本项目,你将学习:

自平衡机器人原理与姿态控制

传感器(IMU)的数据采集与融合

电机驱动与 PWM 控制

语音采集与识别

Wi-Fi 云端交互基础

2. 材料清单(BOM)

成本参考:基础版约 200–250 元/台

3. 工具准备

电烙铁 + 焊锡丝

螺丝刀

热熔胶枪(固定线材)

3D 打印机(可选,或外包打印)

万用表(调试用)

电脑(Windows / Mac / Linux)

4. 硬件结构与组装

4.1 硬件连接示意

4.2 组装步骤

安装电机与轮子

将两只电机固定在底盘两侧,保持对称

轮子轴向要平行,减少偏移

固定电机驱动模块

电机 A、B 接到驱动输出端,驱动输入接主控 PWM 引脚

安装主控板(ESP32-S3)

使用铜柱或螺丝固定在底盘中间位置

接入 IMU(MPU-6050)

用 I²C(SCL、SDA)连接到 ESP32

安装麦克风和功放

麦克风尽量朝上,远离电机

功放板与喇叭用热熔胶固定

接线与理线

电源模块放置在底盘下方或后方

用扎带固定,防止运行时松动

安装上壳

3D 打印件卡扣固定,保留充电口和开关

5. 软件烧录与调试

5.1 开发环境

安装 Arduino IDE

安装 ESP32 开发板支持包(板管理器中搜索 ESP32)

安装以下库:

Wire(I²C)

Adafruit_MPU6050

ESP32Servo(如需)

Adafruit_GFX、Adafruit_SSD1306(OLED)

I2S(音频采集)

ArduinoWebsockets(云端连接可选)

5.2 固件框架

loop() 中分三个任务:

姿态读取与平衡控制(1 kHz)

语音唤醒与离线指令识别(100–200 ms)

表情与网络交互(低优先级)

5.3 烧录

用 Type-C 数据线连接 ESP32

选择正确端口与开发板型号

点击上传

6. 使用方法

开机:长按电源键 2 秒,OLED 显示表情,发出启动音

语音唤醒:说出 “小禾小禾”(或你设定的唤醒词)

指令示例:

“前进” → 缓慢向前

“后退” → 缓慢后退

“点头” → 模拟点头动作

“唱歌” → 播放内置音频

联网模式(可选):连接 Wi-Fi 后,可用云端对话

7. 安全与注意事项

桌面边缘防护:初期可在桌沿贴挡板,防止跌落

电池安全:禁止过充、过放,充电时勿运行机器人

线材固定:确保线缆不被轮子缠住

调参前:将机器人架在支架上,避免失控跌落

8. 调试技巧

先调自平衡:关闭语音功能,仅调 PID 到能稳定站立

IMU 校准:运行一次加速度计/陀螺仪零偏校准

语音识别:先在安静环境测试,再在室内噪声下优化

编码器闭环:加上速度环可大幅减少漂移

9. 进阶扩展

加装摄像头实现表情识别互动

加装超声波/ToF 避障

增加无线充电底座,实现自动回充

Q

给我生成一个结构爆炸图

A

隔了半天以后,我再在同一个对话里面让它:

Q

帮我生成一个这个桌宠机器人在办公桌上跑动的效果图

它竟然给我换了一个小娃!虽然表情比较调皮,但毕竟不是我原来的那只。

A

不行,我还是要回我原来的那只小娃,于是把原来小娃的图片上传上去,并告诉它:

Q

于是,我原来的小娃带着运动的光环又回来了!

A

我想试试两只娃在一起的效果,主要我也想给微信公众号做一个标题图片。就命令它:

Q

能否放两个机器人在桌上,有一些办公桌的背景,图片比例为21:9,其它不变

瞧,桌面上多了一只,哥俩长得一模一样:

A

瞧,光效和气泡的效果也出来了!

突然想起电影Wall-E中的善良的小Eva,能否给我的小机器人搭配一个Eva呢?

Q

再帮我增加一个类似Wall-E(机器人总动员)电影中的EVA的空中飞行的小机器人的效果?

Eva飞到了小机器人的身边了。

A

这个科幻的Eva是很难实现的,给它搭配个螺旋桨应该不难。

Q

EVA能否做成无人机飞行器的样子?仍保持它的可爱,其它不变

于是,Eva长出了翅膀和尾翼!

A

Q

我希望两个机器人都能够无线充电,帮我生成两个机器人都在无线充电时的效果图

给我生成了这个效果,发现小Eva变样子了,又有了小翅膀,头顶上多了一个螺旋桨。

A

我还是要原来的那只小Eva,它给我送回来了。

让它修改好几次它都没有能给我改过来,就是小平衡机器人如何自己爬到充电板上?小Eva不能一只飞着充电吧?可能是因为最初它给出的结构有关。

想起来它曾莫名其妙给我换过一个小机器人,我让它三个在一起看看什么效果,把它三个的照片传上去:

Q

咦,一家三口哎,莫非在它最初的设定里,早就确定了他们的角色定位?

A

从创意到成品:

方案设计

器件选型

电路设计

软件编程

算法实现

结构设计

外壳包装

广告宣传

使用说明书

实验教程

.....

GPT-5都可以为你出谋划策、帮你检查、优化

还有更多的功能等到我们去挖掘。

这也许是一种崭新的体验式教学方式,让年轻人爱上电子、轻松制作、有更多的创新。

AI会代替掉很多人的工作,但它也会让我们腾出时间做更多有趣、有创造性的事情!

83岁老人排队20分钟只为试穿:背后是3.1亿老人的"行动自由"梦

2025世界机器人大会刚刚落下帷幕,一组数据让人印象深刻:130万人报名观展,近2000人试穿体验杭州智元研究院的髋部助行外骨骼,展位人均排队时长15-20分钟。据该研究院在世界机器人大会上的统计,试用人群覆盖全年龄段及多国家,包括美英韩国、东南亚及中亚地区,最大年龄试用者83岁。这个数据背后,折射出的不仅是技术创新的魅力,更是中国3.1亿老年人对"行动自由"的迫切需求。

人形机器人视觉、触觉、定位传感技术分析

人形机器人作为具身智能的重要载体,核心在于通过感知层与认知层的协同,实现对环境的动态识别、自主学习及交互响应。除人形机器人力觉/力矩传感器之外,视觉、触觉、定位传感三类感知技术逐渐被产业关注,正在成为人形机器人实现类人化交互的核心支撑。

从设计到生产

灏域为您提供

全产业链解决方案

开始我们的合作

+86 18600523371