一、CloudMatrix384 系统架构与技术解析

1. 模块化设计:

核心单元:38.4kW一体化机柜(含液冷机框、CDU、管路)。

灵活扩展:支持多柜级联,按需部署,降低初始投资。

工厂预置: 冷板、歧管、快换接头预安装,提升部署效率50%。

2. 高效冷板技术:

精准贴合:针对鲲鹏/昇腾等芯片定制微流道冷板,热阻低至0.03°C·cm²/W。

全栈覆盖:CPU、GPU、内存、电源等关键发热部件均配备液冷冷板(>90%热量被液体带走)。

低流阻设计: 优化流道结构,减少泵功耗。

3.冷板微流道设计(关键突破)

拓扑优化结构:采用仿生树状分形流道(Branching Fractal Design),流道宽度0.5-1.2mm,确保水流覆盖芯片热点区域(如GPU角落)。

材料工艺:冷板主体为6061铝合金,内部嵌入铜合金微管(导热系数>380W/mK),通过真空钎焊实现零泄漏。

热界面材料(TIM):使用液态金属填料(镓基合金,导热系数25W/mK),相比硅脂热阻降低60%。

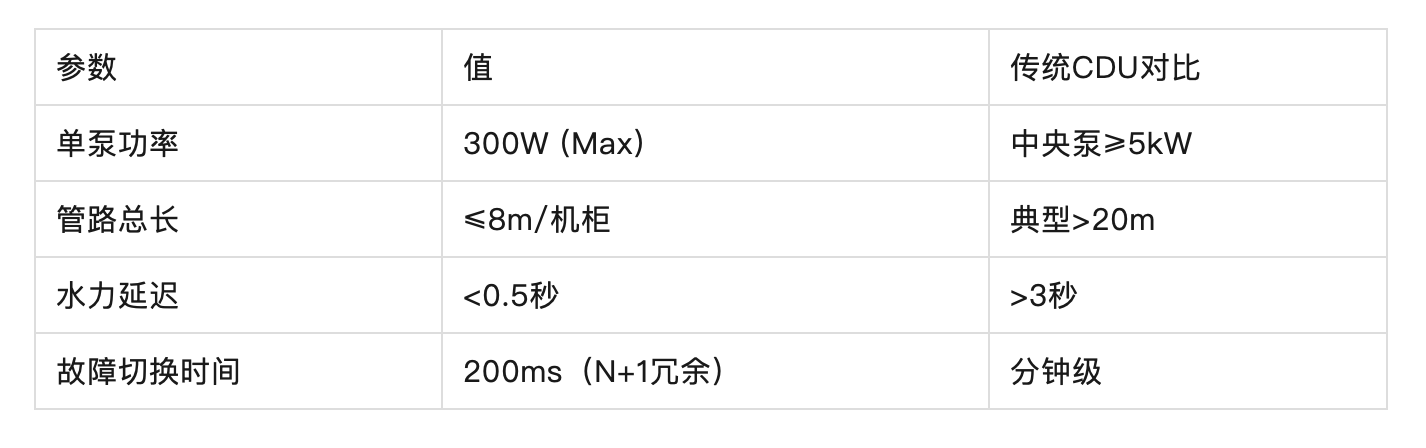

4. 去CDU架构:

创新点: 柜内集成分布式泵模块,替代传统中央CDU。

价值:缩短管路60%,降低漏水风险;提升系统可靠性(N+1冗余泵)。

5. 智能管理系统:

iCooling@AI:实时监测水温、流量、功耗,动态调节泵速与冷量分配。

预测性维护: 基于大数据分析预警管路堵塞、泵故障等风险。

动态调优:基于LSTM模型预测芯片热负载波动,每5秒调节泵速(精度±2%)。

故障预测:通过压力传感器监测流阻变化,提前48小时预警堵塞(准确率92%)。

节能策略:利用室外自然冷源,水温动态设定范围18-45°C,泵功耗降低40%。

6. 兼容性与生态:

支持主流服务器形态(E9000刀片、2288H V5等)。

接口标准化(如SMC 1.0),兼容第三方冷却设施。

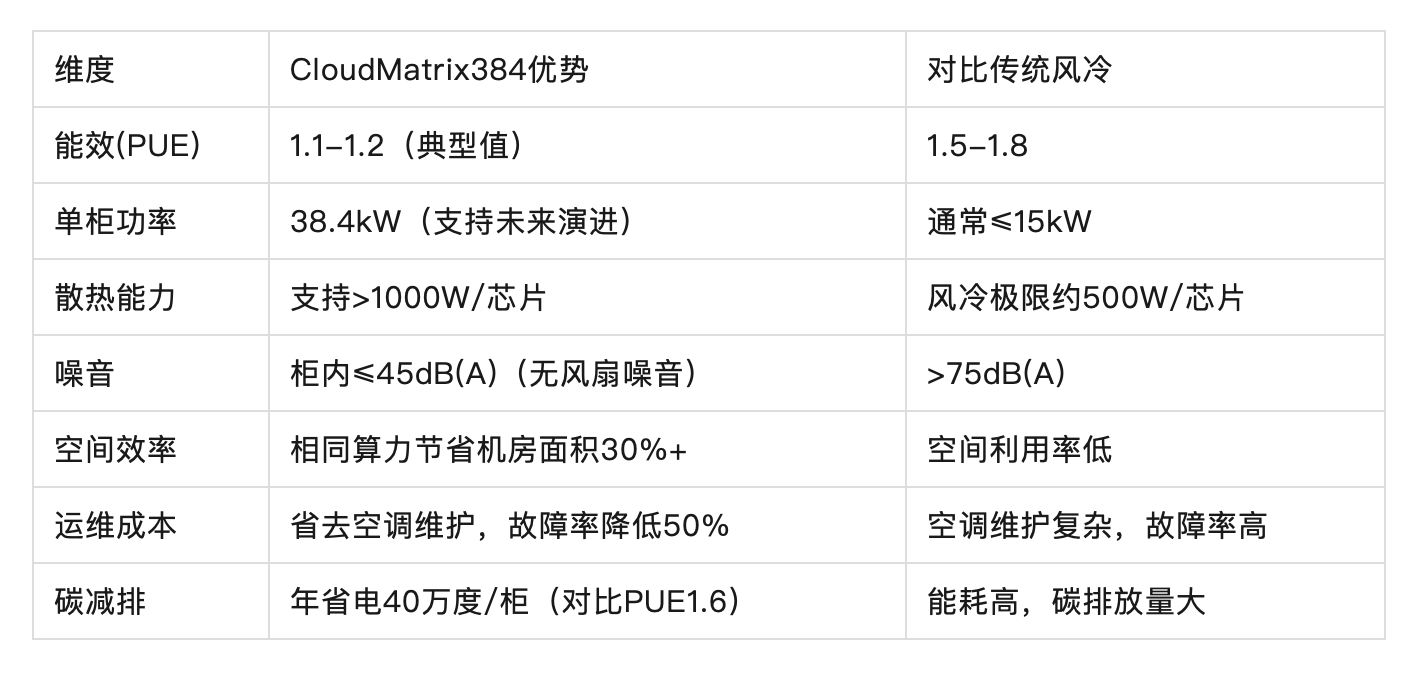

二、 核心优势分析

三、 商业案例实证(2023-2024)

案例1:某AI大模型训练中心(深圳)

规模:200柜(7.68MW算力),搭载昇腾910B芯片

成果:PUE年均1.13(夏季峰值1.18),冷却系统故障率下降73%,年省电费¥860万,10天完成200柜液冷改造(传统方案需8周)

案例2:银行边缘计算节点(上海)

挑战:机房空间仅15㎡,需承载38.4kW算力

方案:2台CloudMatrix384 + 侧向背板换热器

价值:免空调建设,节省机房改造费¥200万,噪音从78dB(A)降至42dB(A),符合办公区标准

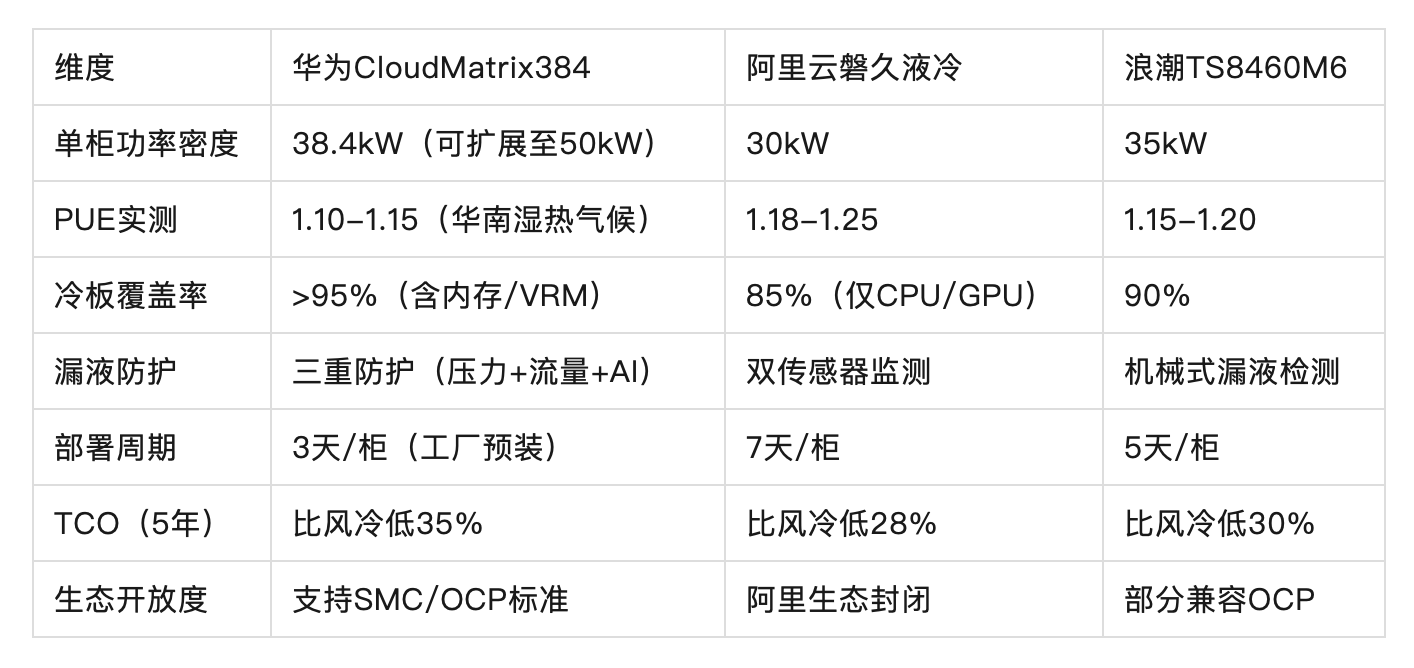

四、 竞品对比分析(2024主流液冷方案)

关键差距:华为在智能运维(iCooling@AI)和分布式泵架构上领先,阿里强于云平台集成,浪潮以性价比见长。

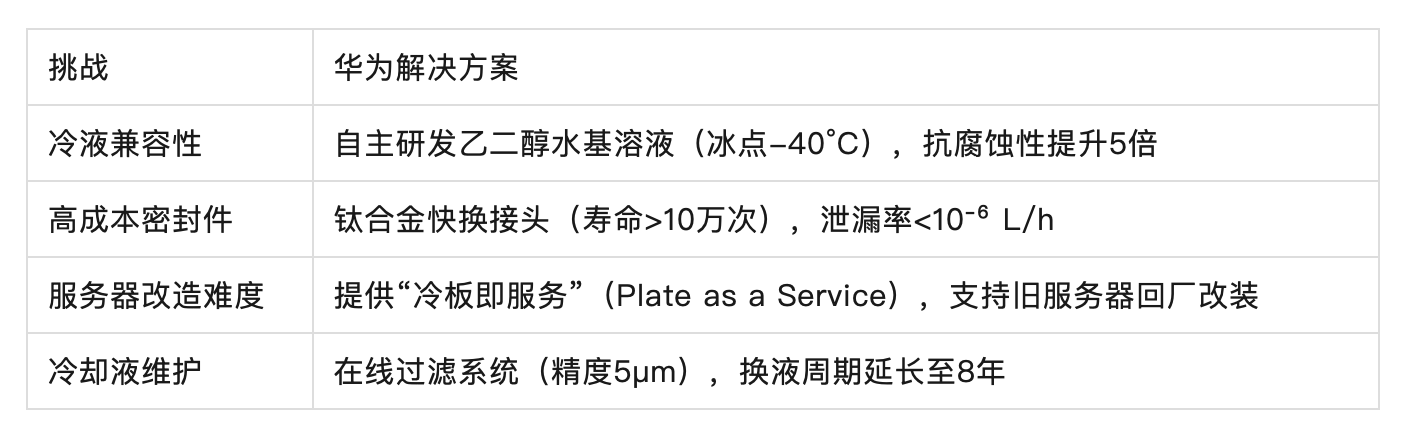

五、 技术挑战与应对策略

中兴通讯—相变浸没式液冷系统研究

数据中心的冷却技术在过去几十年中经历了巨大的演变,从早期的远端风冷发展到近端风冷,再到冷板液冷的批量成熟应用,以及目前正在研究的浸没式液冷。这一演变的主要驱动力包括数据中心计算密度和热流密度的不断增加,以及对能效(PUE)、总拥有成本(TCO)和可持续性的优化需求。

基于关节协同控制的仿人双足机器人设计及优化

随着智能仓储的发展,对能在复杂环境中自主导航、适应多样任务的移动机器人的需求日益增强。尽管当前在通过性与机动性方面,双足机器人相较轮式、履带式及多足式平台尚不具有显著优势,但其结构类人、形态自然,具备高自由度的动作表达与环境适应能力,使其在执行仿人动作、人机交互任务以及在以人为中心的环境中作业方面展现出独特潜力。

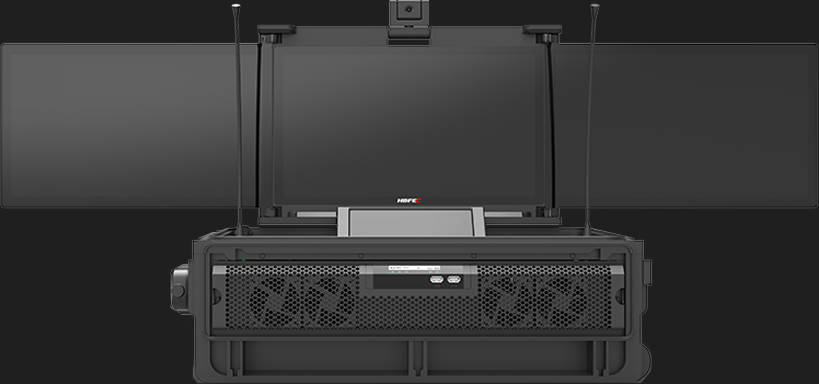

从设计到生产

灏域为您提供

全产业链解决方案

开始我们的合作

+86 18600523371