前言

随着人工智能服务器对散热需求的不断提升,冷板液冷技术成为解决高功耗热管理的关键方案。GB300在1U机箱内支持计算节点的冷板液冷散热,总液冷功耗6.9kW,冷却流量约8LPM,同时支持45℃供液温度散热.其架构设计对后续AI服务器液冷方案具有重要的参考价值。本文通过纵向对比GB200的冷板架构方案,深入解析GB300冷板全液冷方案。

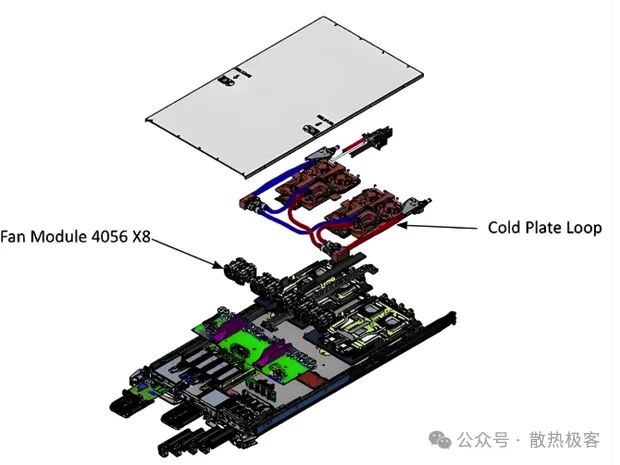

作为GB300的前代方案,GB200采用了当前业内冷板液冷设计,其核心特点是将两个GB200计算单元整合为一个模组,两个冷板模组做并联设计。其主要特点是:

1) 两个冷板模组均配置快插接头,便于快速开断运维;

2) 每个模组内两个B200冷板并联,汇流后再与G200冷板串联;

3) CPU冷板兼顾了LPDDR5内存和CX7网络芯片等低功耗器件的散热。

模组内三块冷板(GPU和CPU冷板)之间通过硬铜管或波纹管连接,CPU冷板尺寸较大。从下图采用波纹管连接冷板的模型上,可清晰看出冷板间的串并联结构。该方案存在以下主要问题:

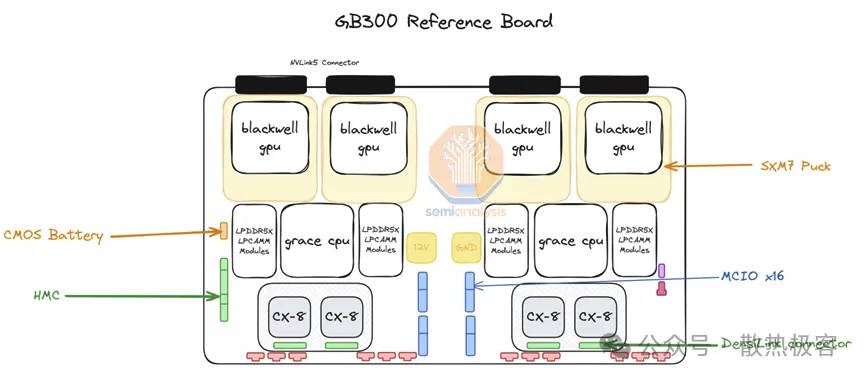

基于GB200的实际验证,GB300方案进行了显著升级。B300 GPU改为SXM7封装,支持从主板拆装,提升了灵活性。

相应的冷板设计方案主要优化点包括:

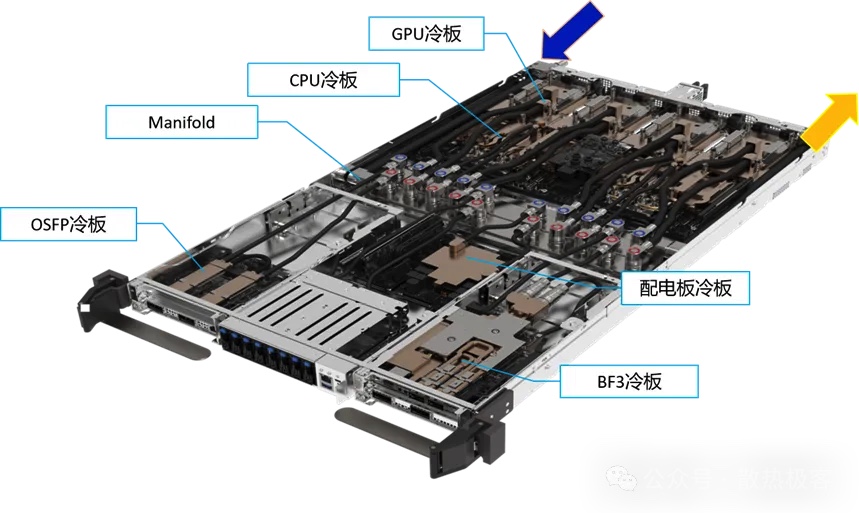

1) 引入分液器(Manifold):节点内设置进出液Manifold,各配置10对快插接头(NVQD03型),实现对GPU、CPU等多器件冷板的并联供液,简化拆装运维。

2) 全冷板覆盖:扩展液冷至配电板(PDB)、OSFP光模块和BF3网卡等器件,确保高功耗关键组件均液冷散热。

3) SSD液冷:为8个M.2 SSD设计专用冷板回路,支持可插拔设计,冷板表面采用TIM确保冷板约SSD接触以降低热阻,并集成耐磨结构以满足插拔需求。

SSD冷板详细设计方案如下图

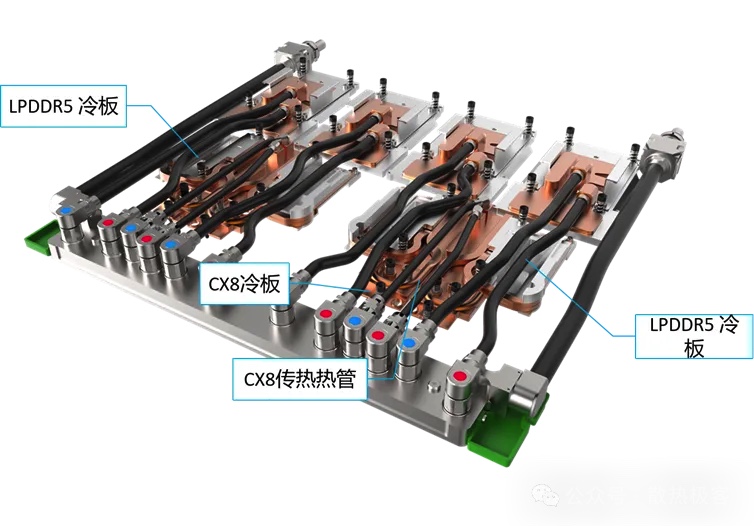

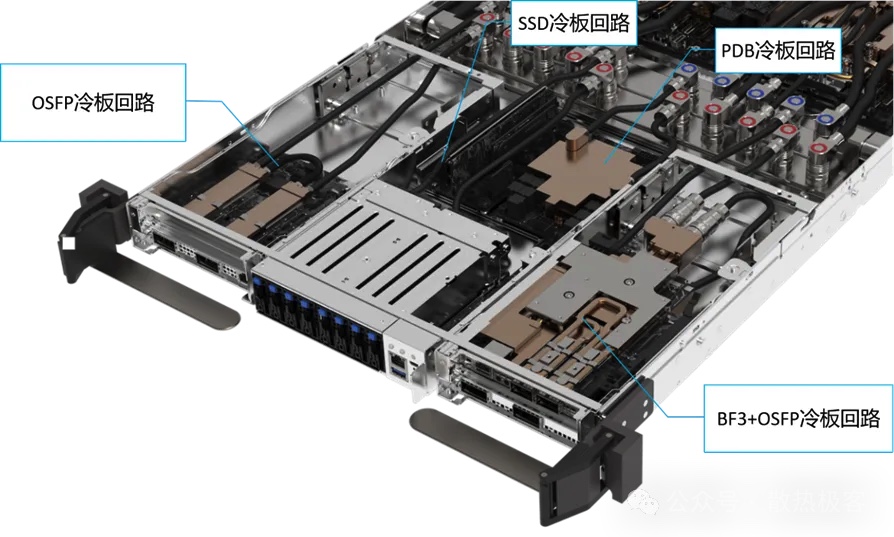

对于两组GB300的冷板设计,从下面的模型中可看出设计方案有如下调整:

1)4个GPU冷板单独进出液,全并联

2)CPU冷板并联设计,LPDDR5和CX8的冷板均通过热管将热量传输到CPU冷板上散热,热管具备一定变形能力,可无需将CPU冷板设计为一体的铜块

上述模型中,所有的快插接头没有明显的区分进出液管的位置,实际节点内设计方案,可明显看出进液快接在上,出液在下。

节点内除两组GB300的6个冷板回路外,其他器件冷板设计如下:

·OSFP冷板:上方两个OSFP冷板串联,通过软管连接确保每个模块冷板可单独浮动,有效液冷;

·SSD冷板:独立回路设计,支持可插拔液冷;

·PDB冷板:单独冷却回路;

·BF3与下方OSFP共用冷却回路:两个OSFP冷板串联后连接BF3冷板,BF3的QSFP光模块通过弯折铜管嵌入导热板冷却。

GB300冷板液冷方案是在GB200冷板架构方案基础上迭代而来,该方案通过Manifold并联架构+支路配置快接优化了流阻和运维效率,所有高功耗器件(如CPU、GPU、NIC、PDB、BF3和SSD)均实现冷板液冷,提升了系统的可靠性和扩展性。

该方案的BF3、OSFP和SSD的液冷方案对于我们后续对该类器件的冷板液冷设计方案有很高的借鉴意义。

从设计到生产

灏域为您提供

全产业链解决方案

开始我们的合作

+86 18600523371